DeepSeek 本地化部署

DeepSeek。DeepSeek:摆脱卡顿!曲线救国使用 DeepSeek 方法大全,但是这里面的方法感觉总是差点意思,要么体验差劲、要么需要翻墙,好用的还需要付费。DeepSeek 呢,我们最终还是要回归正途,因为 DeepSeek 是完全开源的模型,如果你的设备硬件条件过硬,大家都能自己部署。所以今天就跟大家聊聊如何快速在本地部署开源模型,并且部署后如何更好的使用本地模型。为什么要本地部署?

免费:本地的模型部署随便玩,不用担心任何付费,你只需要投入一个好设备就行。

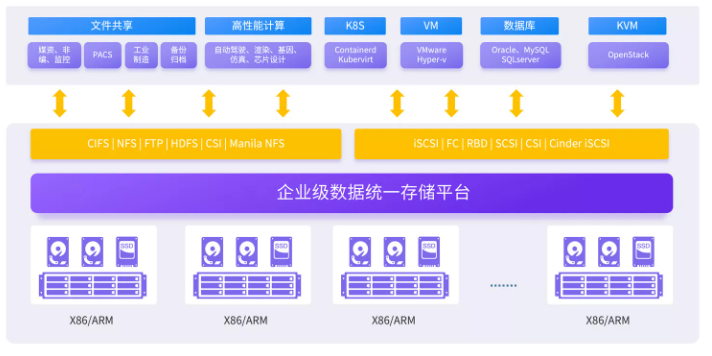

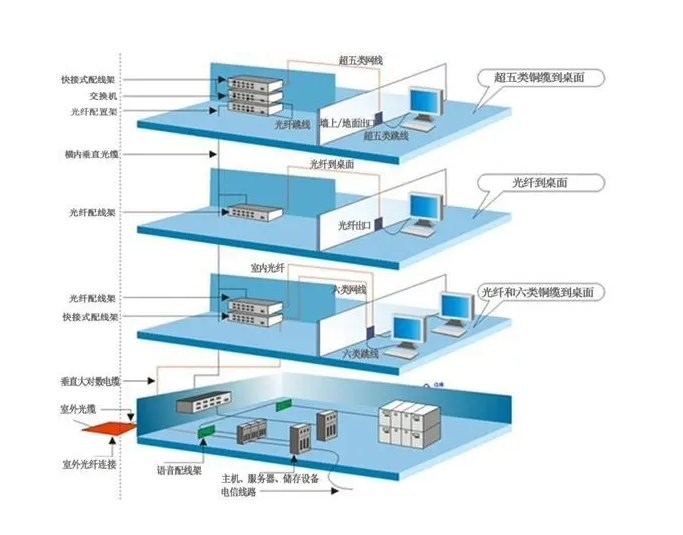

数据隐私:当我们使用云端的大模型时,所有的数据都需要上传到服务器进行处理。这就意味着我们的数据可能会被其他人访问或泄露。如果你要做一些对敏感数据的分析任务,比如公司内网的数据和代码,都需要担心数据泄漏的问题,很多公司也有明确的限制不能将敏感数据泄露给外部模型。而本地部署大模型则可以完全避免这个问题,因为所有的数据都存储在本地,不会上传到云端。

无额外限制:网络上的大模型通常为了符合法律法规以及自身的运营策略,往往会设置严格的内容审查机制。所以在某些敏感话题上,模型的回答会受到限制,即模型给出的回答是基于预设的价值观和规则,而非纯粹基于数据和算法逻辑。而本地部署的模型在内容输出方面相对更加自由,不会有任何内容审查和思想钢印。

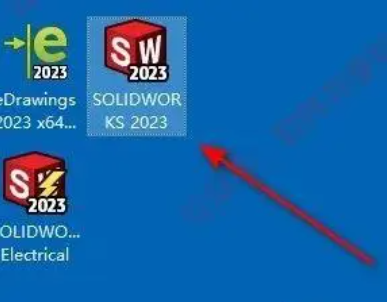

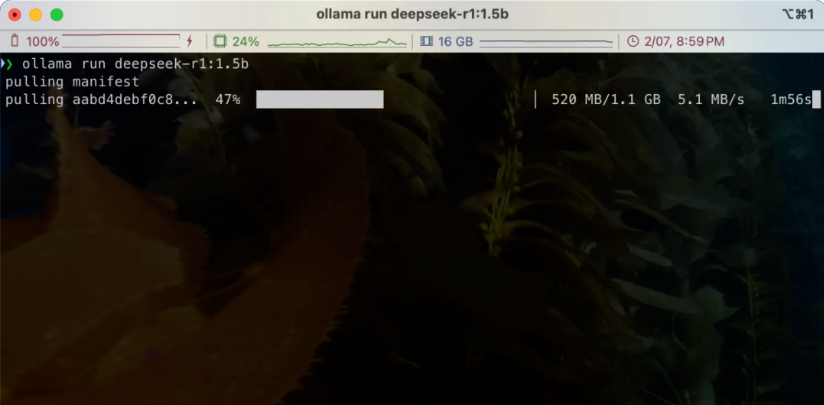

部署步骤:

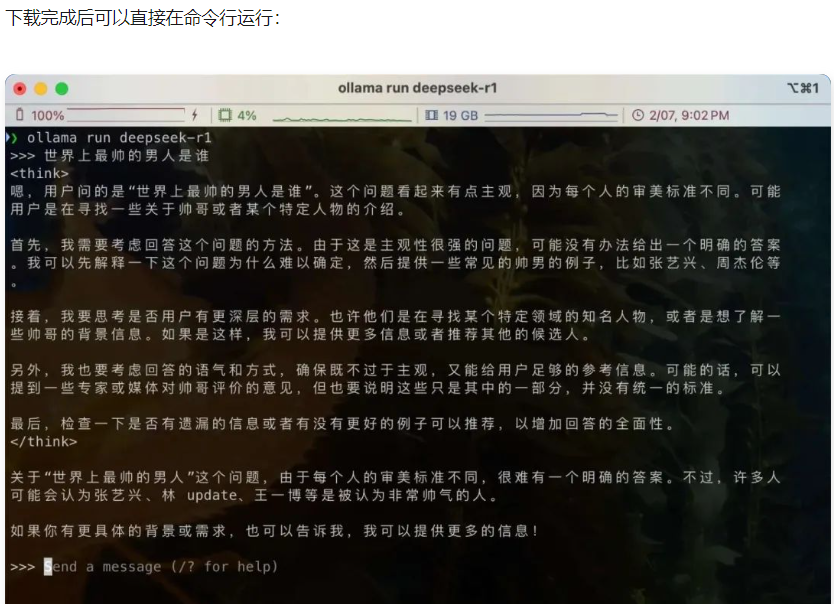

目前我们已经拥有了一个基础的本地模型,但是这种交互方式太不友好了,下面我们通过一些工具来提升我们本地模型的使用体验。

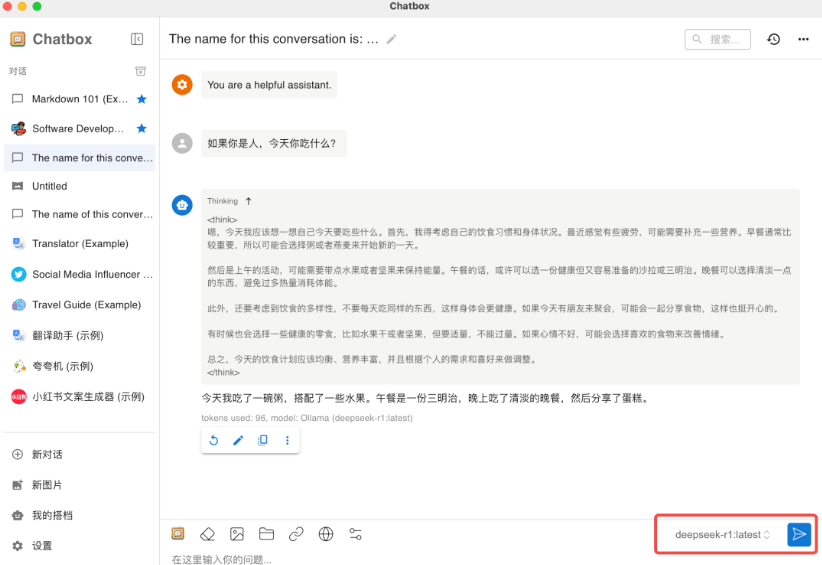

Chatbox + Ollama - 丝滑使用,交互友好

到这里就完成部署了,就可以开始使用了

一个IT界的“救火员”。无论是网络卡顿、服务器罢工还是电脑“发烧”,我都能搞定!各位业界大佬,加个好友吧,说不定哪天您就用得上我啦!

您有任何想法和需求,请致电:

0755-158-1872-2759

一个IT界的“救火员”。无论是网络卡顿、服务器罢工还是电脑“发烧”,我都能搞定!各位业界大佬,加个好友吧,说不定哪天您就用得上我啦!